Model AI mới: Gemini-1.5-Pro-002 và Gemini-1.5-Flash-002

Google vừa ra mắt hai phiên bản Gemini mới, mang đến những cải tiến vượt trội về tốc độ và hiệu suất. Với giá cả phải chăng hơn và khả năng xử lý nhanh hơn, các nhà phát triển giờ đây có thể dễ dàng tích hợp các mô hình AI mạnh mẽ này vào ứng dụng của mình.

Dựa trên nền tảng của các phiên bản thử nghiệm trước đó, Gemini 1.5 Pro-002 và Gemini 1.5-Flash-002 hứa hẹn sẽ mang đến những trải nghiệm người dùng tốt hơn.

Nhìn chung, Google giảm giá và tăng hiệu suất với dòng Gemini 1.5 là với ý định chiếm lĩnh thị trường người dùng AI hơn so với các đổi thủ khác như Claude và OpenAI.

Đặc điểm nổi bật:

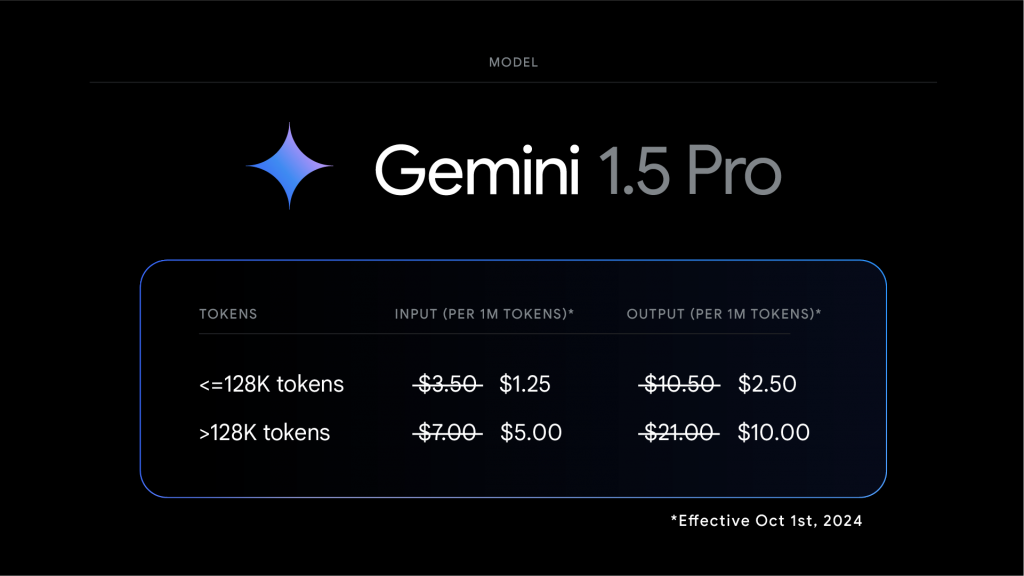

- Giảm giá >50% cho phiên bản 1.5 Pro (cả đầu vào và đầu ra cho lời nhắc <128K).

- Tốc độ giới hạn cao hơn 2x trên 1.5 Flash và cao hơn ~3x trên 1.5 Pro.

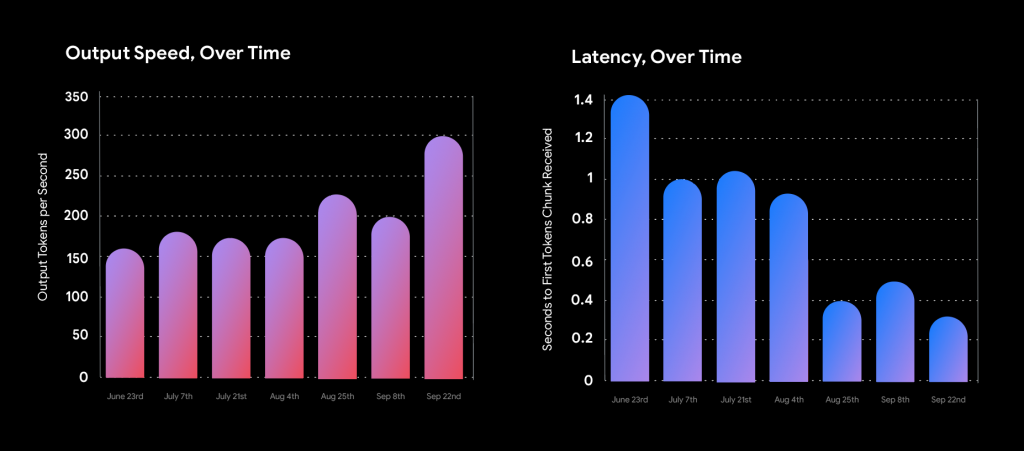

- Tốc độ đầu ra nhanh hơn gấp 2 lần và độ trễ thấp hơn gấp 3 lần.

- Đã cập nhật cài đặt bộ lọc mặc định.

Ưu điểm của dòng Gemini 1.5

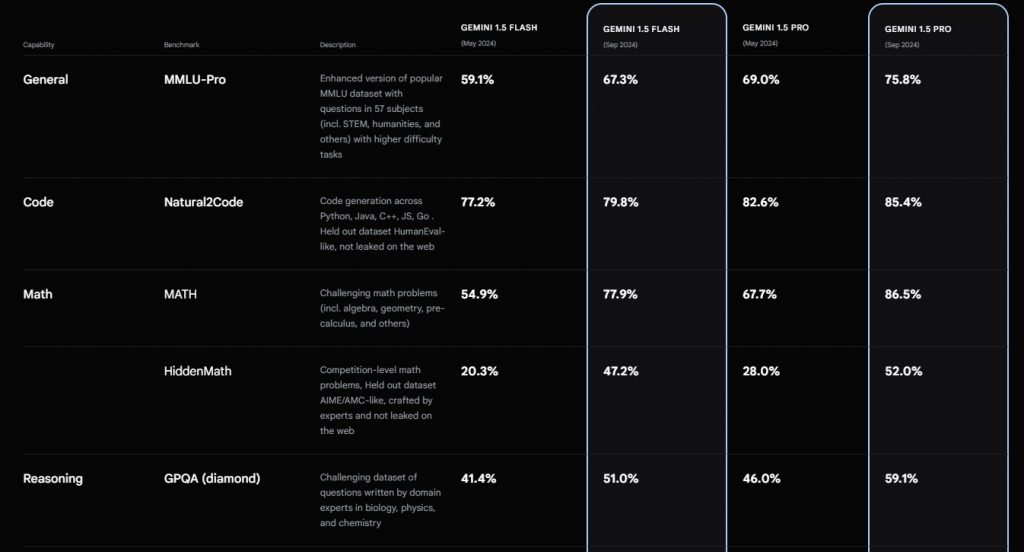

Dòng Gemini 1.5 đã đạt được những tiến bộ vượt bậc, đặc biệt trong lĩnh vực toán học, xử lý ngôn ngữ tự nhiên và hiểu hình ảnh. Các mô hình này không chỉ nhanh hơn và hiệu quả hơn mà còn thể hiện khả năng giải quyết các bài toán phức tạp một cách chính xác hơn.

Với Gemini 1.5, bạn có thể dễ dàng tìm kiếm thông tin từ một lượng lớn tài liệu, từ các bài báo khoa học cho đến các đoạn mã phức tạp. Mô hình này cũng xuất sắc trong việc tạo ra các nội dung sáng tạo dựa trên video, hình ảnh và văn bản.

Các thử nghiệm cho thấy Gemini 1.5 đã vượt trội so với các phiên bản trước đó. Ví dụ, khi đánh giá trên MMLU, một tiêu chuẩn đánh giá phổ biến, Gemini 1.5 đã đạt được kết quả cao hơn 7%. Đặc biệt, trong các bài toán toán học phức tạp, mô hình này đã cải thiện hiệu suất đến 20%.

Nhờ những cải tiến này, Gemini 1.5 trở thành một công cụ hữu ích cho nhiều ứng dụng, từ hỗ trợ nghiên cứu đến phát triển các sản phẩm AI.

Qua những cải tiến mới nhất, hệ thống đã đạt được hiệu quả cao hơn trong việc tạo ra các phản hồi chất lượng, đáp ứng đa dạng yêu cầu của người dùng. Việc tuân thủ nghiêm ngặt các tiêu chuẩn an toàn vẫn là ưu tiên hàng đầu.

Để tối ưu hóa trải nghiệm người dùng, cả hai mô hình đều được thiết kế để trả lời súc tích, dễ hiểu. Cụ thể, độ dài đầu ra trung bình của các tác vụ như tóm tắt, hỏi đáp đã được rút ngắn khoảng 5-20%, giúp tiết kiệm thời gian và tài nguyên.

Giảm giá Gemini 1.5 Pro

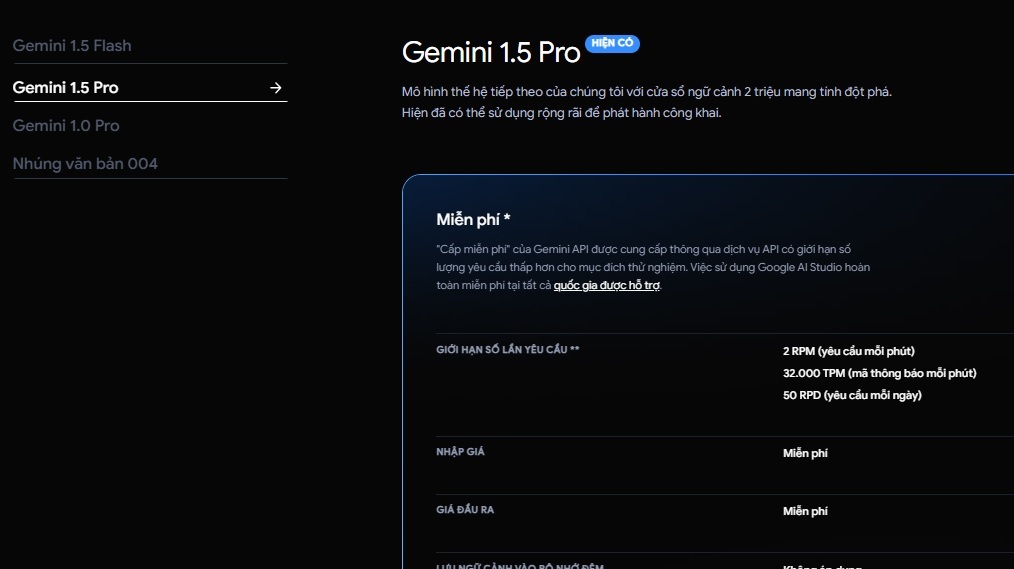

Khả năng xử lý video, tài liệu PDF 1000 trang và cửa sổ ngữ cảnh dài 2 triệu token của Gemini 1.5 Pro tiếp tục mở ra vô vàn ứng dụng sáng tạo.

Để thúc đẩy hơn nữa việc khám phá và phát triển các trường hợp sử dụng mới, kể từ ngày 1 tháng 10 năm 2024, giá token đầu vào, token đầu ra và token lưu trữ bộ nhớ đệm của mô hình Gemini 1.5 Pro sẽ giảm lần lượt 64%, 52% và 64% cho các lời nhắc dưới 128 nghìn token. Với bộ nhớ đệm ngữ cảnh, việc xây dựng các ứng dụng dựa trên Gemini trở nên kinh tế hơn bao giờ hết.

Tăng giới hạn tỷ lệ RPM

Để hỗ trợ tốt hơn cho cộng đồng nhà phát triển, giới hạn tốc độ trả phí cho Gemini 1.5 Flash sẽ tăng lên 2.000 RPM và Gemini 1.5 Pro lên 1.000 RPM, tăng đáng kể so với mức hiện tại.

Trong thời gian tới, giới hạn tốc độ API Gemini dự kiến sẽ tiếp tục được nâng cấp, mở ra nhiều cơ hội hơn cho các nhà phát triển.

Tốc độ đầu ra nhanh hơn gấp 2 lần và độ trễ ít hơn gấp 3 lần

Bên cạnh đó, các cải tiến về hiệu suất đã giúp giảm độ trễ của 1.5 Flash xuống còn một nửa và tăng đáng kể tốc độ đầu ra, mở ra khả năng ứng dụng mới cho các mô hình mạnh mẽ nhất.

Ra mắt mô hình Gemini 1.5 Flash-8B thử nghiệm

Phiên bản nâng cấp của mô hình Gemini 1.5, mang tên “Gemini-1.5-Flash-8B-Exp-0924”, đã chính thức ra mắt, mang đến những cải tiến đáng kể về hiệu năng cho cả văn bản và đa phương thức.

Người dùng có thể trải nghiệm phiên bản mới này ngay trên Google AI Studio và Gemini API.

Nhờ phản hồi tích cực từ cộng đồng nhà phát triển, chúng tôi sẽ tiếp tục điều chỉnh quy trình phát hành để đáp ứng tốt hơn nhu cầu của người dùng. Đồng thời, người dùng Gemini Advanced cũng sẽ sớm được trải nghiệm phiên bản trò chuyện tối ưu hóa của Gemini 1.5 Pro-002.