OpenAI, công ty công nghệ hàng đầu trong lĩnh vực trí tuệ nhân tạo, vừa tổ chức sự kiện DevDay 2024 đêm qua theo giờ Việt Nam.

Sự kiện này đã mang đến nhiều tin tức hấp dẫn cho cộng đồng công nghệ toàn cầu. Hãy cùng điểm qua 4 cập nhật chính, hứa hẹn sẽ định hình tương lai của AI trong những năm tới.

Bài viết liên quan: OpenAI o1 – Mô hình lý luận mới để giải quyết các vấn đề khó

OpenAI DevDay 2024 có gì ?

OpenAI, công ty công nghệ hàng đầu trong lĩnh vực AI, vừa tổ chức sự kiện DevDay 2024 đêm qua theo giờ Việt Nam. Sự kiện này đã mang đến nhiều tin tức hấp dẫn cho cộng đồng công nghệ toàn cầu.

Hãy cùng điểm qua 4 cập nhật chính, hứa hẹn sẽ định hình tương lai của AI trong những năm tới.

Prompt Caching: Tiết kiệm chi phí, tăng hiệu quả

Prompt Caching giúp giảm đáng kể độ trễ (lên đến 80%) và chi phí (lên đến 50%) khi sử dụng các API của OpenAI.

Điều này được thực hiện bằng cách định tuyến các yêu cầu API đến các máy chủ đã xử lý các prompt tương tự trước đó, giúp giảm tải xử lý từ đầu. Prompt Caching hoạt động tự động cho tất cả yêu cầu API mà không cần thay đổi mã và không mất thêm phí.

Các mô hình hỗ trợ Prompt Caching:

- GPT-4o

- GPT-4o-mini

- O1-preview

- O1-mini

Cấu trúc prompt tối ưu: Để đạt được hiệu quả từ Prompt Caching, bạn nên đặt những nội dung tĩnh như hướng dẫn và ví dụ ở đầu prompt. Nội dung thay đổi, ví dụ như thông tin người dùng, nên đặt ở cuối. Quy tắc này cũng áp dụng cho hình ảnh và công cụ, khi chúng cần phải giống hệt nhau trong mỗi lần yêu cầu.

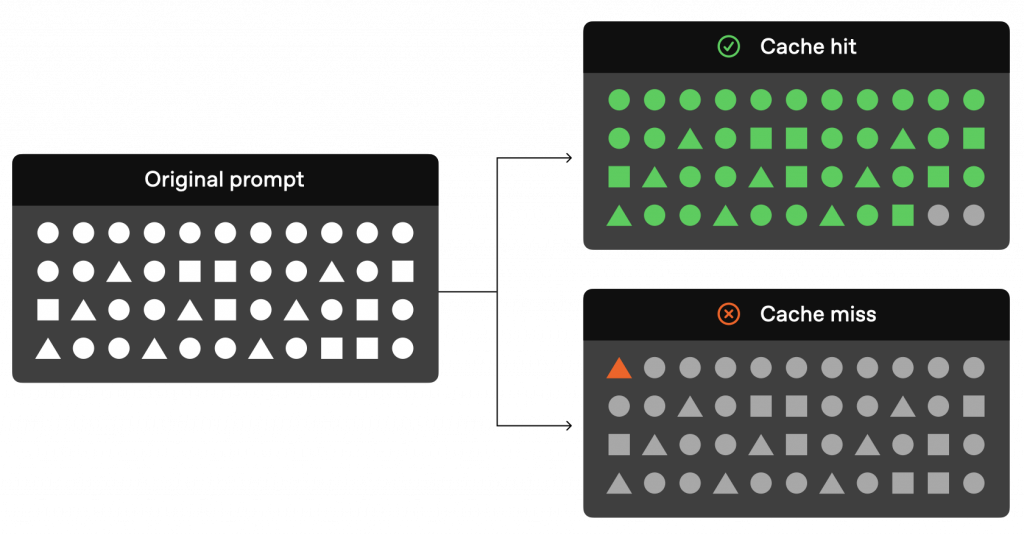

Quy trình hoạt động của Prompt Caching:

- Kiểm tra bộ nhớ cache: Hệ thống kiểm tra phần mở đầu (prefix) của prompt có được lưu trong cache hay không.

- Cache Hit: Nếu phần mở đầu trùng khớp, hệ thống sử dụng kết quả đã lưu, giảm đáng kể độ trễ và chi phí.

- Cache Miss: Nếu không tìm thấy phần mở đầu, hệ thống sẽ xử lý toàn bộ prompt và lưu trữ phần mở đầu cho các yêu cầu trong tương lai.

Các phần mở đầu được cache thường tồn tại trong 5 đến 10 phút, và có thể kéo dài đến 1 giờ trong thời gian ít lưu lượng truy cập.

Tận dụng Prompt Caching không chỉ giúp bạn tiết kiệm chi phí mà còn nâng cao hiệu quả hoạt động, đặc biệt với các yêu cầu có độ dài lớn hơn 1024 tokens.

Nói đơn giản cho dễ hiểu như prompt bạn đang để như thế này khi gọi API:

Bạn là chuyên gia tóm tắt thông tin..... Đây là thông tin bạn cần phải tóm tắt "{information}" (trong đó information là nội dung luôn thay đổi). Dựa vào thông tin đó, hãy tuân thủ những quy tắc..v..v...

Nếu bạn muốn sử dụng Prompt Caching, hãy đặt nội dung thay đổi đó xuống cuối prompt.

Bạn là chuyên gia tóm tắt thông tin..v.. Dựa vào thông tin dưới đây, hãy tuân thủ những quy tắc..v..v... Đây là thông tin bạn cần dựa vào "{information}" (trong đó information là nội dung luôn thay đổi).

Vision Fine-Tuning: Nâng cao khả năng "nhìn" của AI

Một trong những thông báo đáng chú ý nhất tại DevDay 2024 là Vision Fine-Tuning. Tính năng này cho phép:

- Dạy AI “nhìn” và “hiểu” hình ảnh với độ chính xác cao

- Mở ra tiềm năng ứng dụng rộng rãi trong nhiều lĩnh vực:

- Xe tự lái: Nâng cao khả năng nhận diện đối tượng và tình huống giao thông

- Y tế: Hỗ trợ chẩn đoán hình ảnh, phát hiện bệnh sớm

- An ninh: Cải thiện hệ thống giám sát và nhận dạng

Vision Fine-Tuning hứa hẹn sẽ mang lại bước nhảy vọt trong công nghệ xử lý hình ảnh, mở ra vô số cơ hội cho các ứng dụng AI trong tương lai.

Realtime API: Trải nghiệm hội thoại đa phương thức với độ trễ thấp

Realtime API là giải pháp lý tưởng để tạo ra những trải nghiệm hội thoại đa phương thức với độ trễ thấp. Hiện tại, API hỗ trợ cả văn bản và âm thanh dưới dạng đầu vào và đầu ra, cùng với tính năng gọi hàm.

Dưới đây là một số lợi ích nổi bật của Realtime API:

Chuyển đổi giọng nói trực tiếp: Không cần qua trung gian văn bản, giúp giảm độ trễ và tạo ra âm thanh tinh tế, tự nhiên hơn.

Giọng nói tự nhiên, linh hoạt: Mô hình giọng nói có ngữ điệu tự nhiên, có thể điều chỉnh theo ngữ cảnh, ví dụ như cười, thì thầm, hoặc thay đổi theo hướng dẫn về ngữ điệu.

Đầu ra đa phương thức đồng thời: Văn bản giúp kiểm duyệt, trong khi âm thanh nhanh hơn thời gian thực đảm bảo phát lại ổn định.

Realtime API giúp tối ưu hóa trải nghiệm người dùng thông qua khả năng tích hợp và tương tác đa dạng, phù hợp với các ứng dụng hội thoại hiện đại.

Trạng thái của phiên bao gồm:

- Phiên họp

- Bộ đệm âm thanh đầu vào

- Các cuộc hội thoại là danh sách các mục

- Phản hồi, tạo ra danh sách các mục

Đọc bên dưới để biết thêm thông tin về các đối tượng này.

Model Distillation: Hiệu suất cao, kích thước nhỏ

Cuối cùng, OpenAI giới thiệu Model Distillation, một kỹ thuật đột phá cho phép:

- Tận dụng đầu ra của mô hình lớn để tinh chỉnh mô hình nhỏ hơn

- Đạt được hiệu suất tương tự trên một tác vụ cụ thể với mô hình kích thước nhỏ hơn

- Giảm yêu cầu về tài nguyên tính toán và lưu trữ

Model Distillation mở ra cơ hội:

- Triển khai các ứng dụng AI mạnh mẽ trên thiết bị di động và IoT

- Tối ưu hóa chi phí vận hành cho các doanh nghiệp

- Đẩy nhanh quá trình phát triển và triển khai các ứng dụng AI

Kết luận

OpenAI DevDay 2024 đã chứng minh rằng cuộc cách mạng AI vẫn đang tiếp diễn mạnh mẽ.

Với 4 cập nhật quan trọng – Prompt Caching, Vision Fine-Tuning, Realtime API và Model Distillation – OpenAI tiếp tục dẫn đầu trong việc đưa AI trở nên rẻ hơn, dễ dùng hơn và hiệu quả hơn. Những cải tiến này không chỉ mở ra cơ hội mới cho các nhà phát triển và doanh nghiệp, mà còn hứa hẹn mang lại những ứng dụng AI đột phá, có tác động tích cực đến cuộc sống hàng ngày của chúng ta.